Ranking użytkowników

Popularna zawartość

Treść z najwyższą reputacją w 11.07.2019 uwzględniając wszystkie miejsca

-

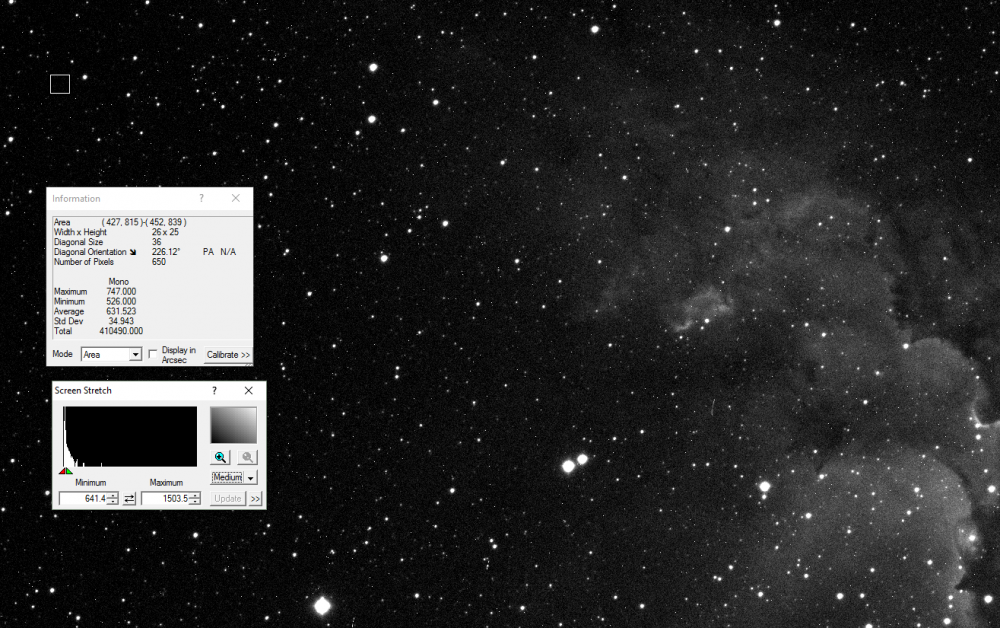

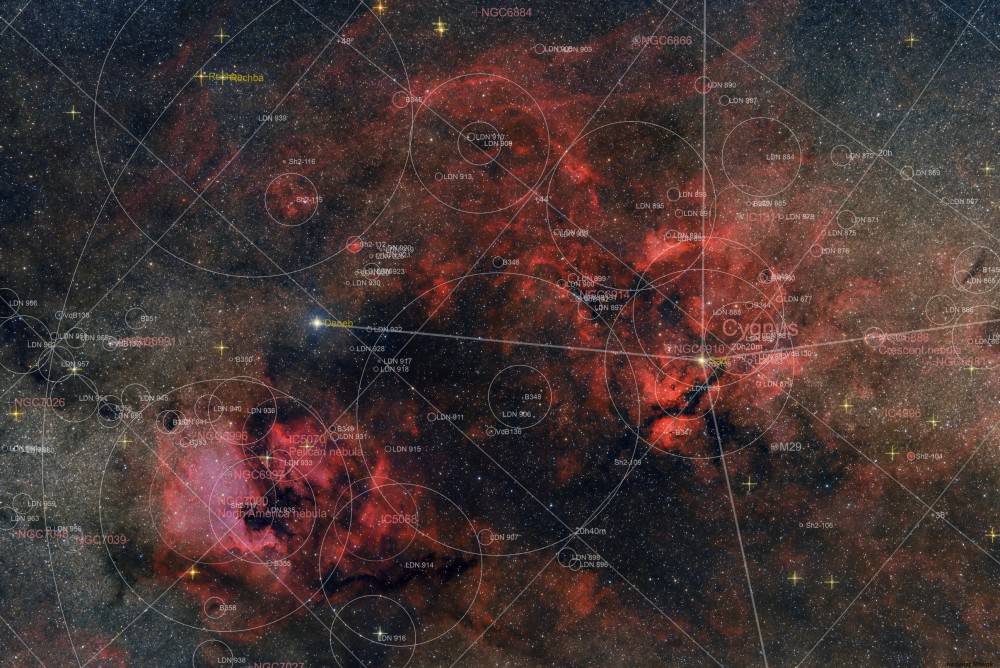

Od dawna miałem w swoim planach niecne zamiary wobec Nikona D610 i w końcu... nabyłem drugi egzemplarz, który kilka dni później przeszedł u kolegi Michała stosowną operację plastyczną, w wyniku której, niebo stało się dla mnie (i dla aparatu) "bardziej czerwone". Poniżej pierwsze światło i debiucik mojego D610mod. Materiał zebrany 2 tygodnie temu w Roztokach Górnych przez 2 noce. Parametry: 47x120s Samyang135mm/[email protected]+NikonD610mod@iso1600 + HEQ5 Celem stał się kompleks wodorowych mgławic w centrum Łabędzia. Chyba było warto :) i wersja dla kartografów: pozdr i9 punktów

-

8 punktów

-

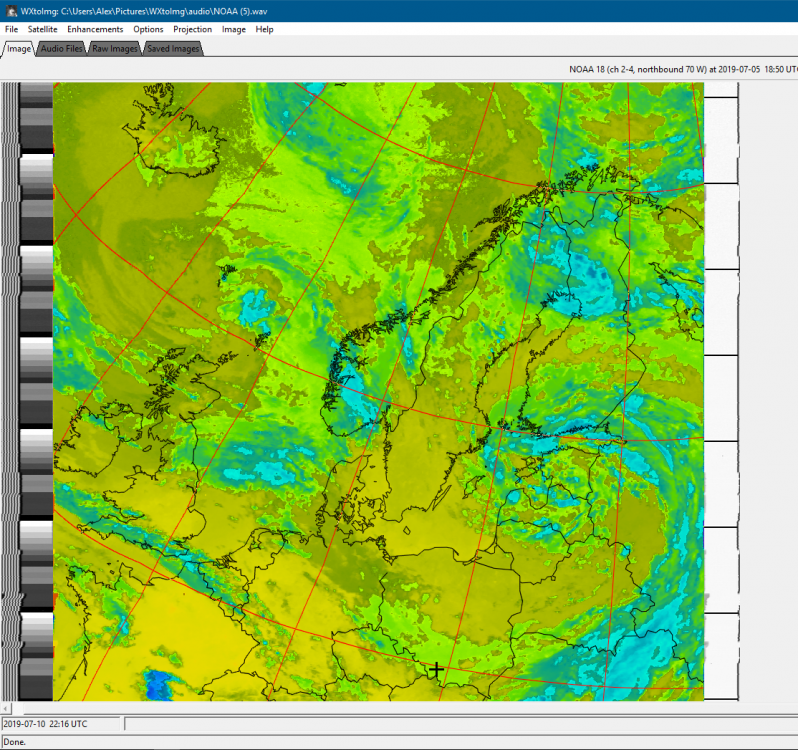

Dzień Dobry, Z tej strony Filip (ten od Pani Ciekawskiej). Dotychczas na forum nie egzystowałem i można kojarzyć mnie jedynie z ostatniego Zlotu. Wygłaszałem wtedy prelekcje o mapowaniu wodoru w Drodze Mlecznej domowym radioteleskopem. Dziś jednak chciałbym pokazać coś bardziej przyziemnego, w formie ciekawostki pokazać co nam tam nad głowami piszczy. Mając na uwadze że to jednak forum astronomiczne, zezwalam na opieprzenie mnie za obserwacje prowadzone w megahercach, a nie terahercach Otóż ponad 50 lat temu zaczęto wykorzystywać satelity do prognozowania pogody. Jak na tamte czasy był to przełom, możliwość oglądania ruchu i ułożenia chmur z orbity. Taki satelita meteorologiczny był wystrzeliwany na orbitę pokroju SSO* lub polarnej i przelatywał w dowolnym miejscu na ziemi 2 razy dziennie - u nas w okolicach porannych i wieczornych (orbita jest zsynchronizowana ze słońcem). Satelita ciągle transmitował sygnał analogowy przesyłający linię po linii czarno-biały obraz z orbity. Odebrać to mógł każdy dysponujący odpowiednim sprzętem i specjalnym dekoderem sygnału. Sprzęt taki oczywiście trafił do instytutów meteorologicznych, a te na podstawie danych z tych satelitów prognozowały pogodę. * https://en.wikipedia.org/wiki/Sun-synchronous_orbit Z perspektywy dnia dzisiejszego technika ta jest bardzo przestarzała. Obecnie posiadamy satelity geostacjonarne dające nam zdjęcia całej półkuli w powalającej jakości co 5 minut, a do tego wiszą ciągle w tym samym miejscu na niebie. Nie jest to polowanie na przelot tak jak w wypadku tych pierwszych. Teraz satelity na orbitach SSO wykorzystuje się do zbierania innych danych (są na względnie niskich orbitach 700-1200km) niż ładne zdjęcia chmurek z orbity, jednakże nikt nie widział przeciwwskazań aby i przy okazji je robiły. W ten oto sposób ostatni satelita NOAA używający standardu APT w celu przesyłania zdjęć na Ziemię został wystrzelony w 2009 roku - czyli wtedy 50-cio letni analogowy standard trafił na orbitę... Nowsze satelity NOAA niestety już nie raczą nas obrazkami przesyłanymi tym standardem. Wspominam tu ciągle o jakimś tajemniczym APT, może zadaje ktoś tu sobie pytanie czym to jest. Otóż jest to sposób analogowej transmisji obrazu za pomocą dźwięku - nomen omen fal radiowych w modulacji FM - tej samej, dzięki której w samochodzie nie jeździmy w ciszy. Standard ten przesyła obraz Ziemi linijka po linijce prostopadle do kierunku ruchu satelity. Przesyła on 2 zdjęcia po sobie - jedno w spektrum widzialnym, drugie w podczerwieni. Im dłużej (im niżej nad horyzontem) udaje nam się czysto odbierać satelitę, tym dalsze zakątki możemy zobaczyć. Sygnał sam w sobie brzmi dosyć ciekawie i można go posłuchać poniżej (oszczędzę sobie porównywanie go do karetki, pani Grażynki i kierunkowskazu i najzwyczajniej umieszczę próbkę). Sygnał ten jest najczystszym jaki sam mam w zanadrzu. >LINK< Obecnie na naszym niebie przelatują 3 satelity NOAA, które jeszcze nadają tego typu sygnał: NOAA 15, NOAA 18, NOAA 19. Pierwszy z tych satelitów jest 2 lata starszy ode mnie, bo został wystrzelony w 1998 roku, a ostatni w 2009. Nieprzypadkowe jest że opowiadam teraz akurat o nich. To są trzy ostatnie satelity, które wysyłały i będą wysyłać te zdjęcia. Pierwszy z nich ma już poważne problemy techniczne i odlicza dni do odejścia na inny świat. Najbliższe lata są ostatnimi chwilami na ich obserwacje bowiem zaraz zdjęcia z nich odejdą w niepamięć niczym flary świętej pamięci satelitów systemu Iridium. Te są o tyle ciekawe, że odbieranie ich w dzisiejszych czasach jest banalnie proste. W praktyce gdyby Wasze radio samochodowe dało radę wejść na 137.9 MHz to stałoby się odbiornikiem zdjęć z orbity . Do ich odbioru wystarczy dowolne radio FM które wejdzie na częstotliwość 137.9 MHz, śmieszna antenka i program do zdekodowania. Jeśli byłaby chęć i potrzeba, mógłbym opisać jak za mniej niż 50 złotych zrobić sobie zestaw do odbioru takich zdjęć. Dzisiaj jednak chciałem pokazać co razem z Ciekawską udało mi się ostatnio upolować. Zdjęcia w domyśle nie zawierają żadnych konturów i siatek - można je nałożyć w odpowiednich programach. Na marginesie dodam też, że satelity te nadają te zdjęcia tylko czarno białe, a kolory które tu widzimy są sztuczne. Na końcu zaznaczę że istnieją jeszcze inne satelity pozwalające odbierać zdjęcia - jednakże nie są już takie milutkie w odbiorze. Każde zdjęcie zawiera także dane o temperaturze. Paski widziane z boku to telemetria satelity i paski które kiedyś służyły do synchronizacji odbiornika. Tymczasem ja kończę ten elaborat licząc że komuś się to będzie miło czytało. A tych którym brakło cierpliwości zapraszam do oglądania obrazków w poście poniżej, ja nie mogę umieszczać jeszcze zdjęć ?7 punktów

-

Witam mam pytanie Jaki polecacie program do obróbki astro fotografii? Dodam że zależy bardziej na aplikacji na telefon ? Pozdrawiam i życzę pogodnego nieba ?4 punkty

-

Dziś do naszej grupy ekspertów dołączył Dominik Woś - człowiek legenda polskiej astrofotografii, członek wielu wypraw pod południowe niebo, autor wielu niesamowitych, wręcz referencyjnych prac. Dziś jest także administratorem forum Astromaniak. 1. Droga Mleczna nad torpedownią Zdjęcie ma swój specyficzny klimat. Łączy umiejętnie elementy krajobrazu z przepięknym obrazem wschodzącej Drogi Mlecznej. Bardzo ładnie zarejestrowały się takie skarby jak Mgławica Ameryka Północna (NGC7000), wodorowe okolice Sadra, czy też obszar mgławicy emisyjnej w Cefeuszu (IC1396). Oczywiście klimat zdjęcia lekko psuje delikatnie zaświetlenie sztucznym światłem i zauważalna dystorsja samego obiektywu, powodująca rozciągnięcie gwiazd w rogach kadru, ale na pochwałę zasługuje kompozycja kadru i odwaga za jego szeroki kąt. Doskonale widać, że modyfikowany Canon jest bardzo poważnym narzędziem w rękach nawet niezbyt doświadczonych astrofotografów. 2. Messier 51 Zdjęcie zostało zrobione z centrum Radomia i do tego niezmodyfikowanym Canonem. Pomimo tego, autorowi bardzo ładnie udało się uchwycić, w zasadzie klasyk w astrofotografii, czyli galaktyki M51 i NGC5195 oraz sporo małych galaktyk w tle. Jak na Canona galaktyki mają ładny kolor i fajnie widać już ich galaktyczne halo, a tło wydaje się być naturalne. Brakuje trochę koloru dla gwiazd. Przydałyby się też pewnie krótsze ekspozycje dla samych jąder galaktyk, które wydają się lekko przepalone. Pewnie wykorzystanie dłuższej ogniskowej byłoby z korzyścią dla M51 i jej towarzyszki ale szerokie galaktyczne kadry też mają swój urok. 3. Strzelec i Tarcza Łoł, zgodnie z opisem jest to pojedyncza 2-minutowa ekspozycja. Wspaniale widoczne są najważniejsze skarby Strzelca, w tym M8 (Mgławica Laguna) i jej towarzyszka M20 (Trójlistna Koniczyna), M24 (obłok Strzelca), Mgławice M16 (w Ogonie Węża) i M17 a nawet gromada kulista M22 oraz liczne ciemne mgławice (Barnardy). Fotografowanie tego obszaru nieba, który w naszych szerokościach geograficznych nie góruje przecież wysoko nad horyzontem wymaga w miarę dobrych warunków pod względem ciemnego nieba oraz odwagi aby przesunąć kadr dość nisko, narażając się na wynikające z tego gradienty. Autor zdjęcia doskonale poradził sobie z tymi zagrożeniami. Gdyby jednak zwiększyć trochę liczbę ekspozycji i je połączyć, mogłoby to pchnąć w zdjęcie dodatkowe wartości pod względem kolorystyki i kontrastu.2 punkty

-

2 punkty

-

2 punkty

-

2 punkty

-

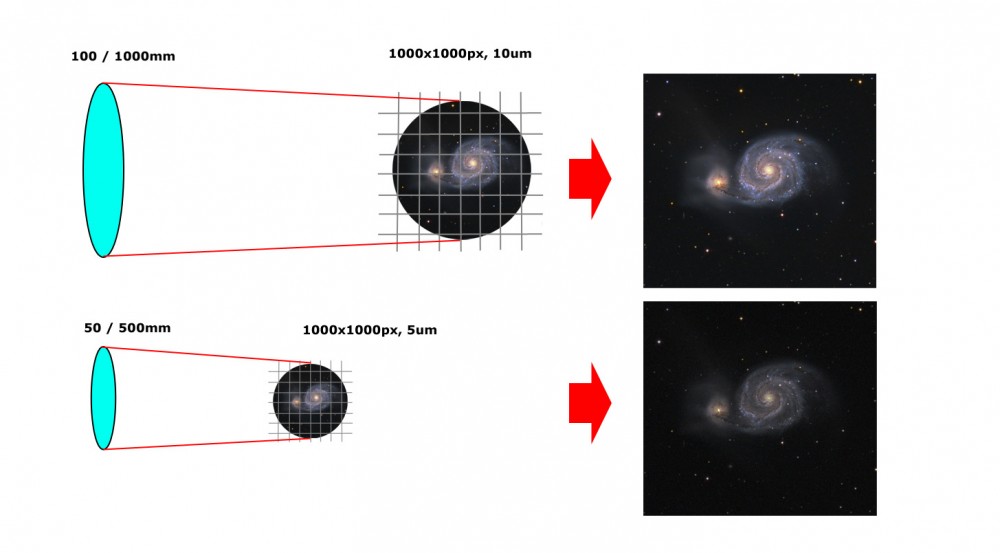

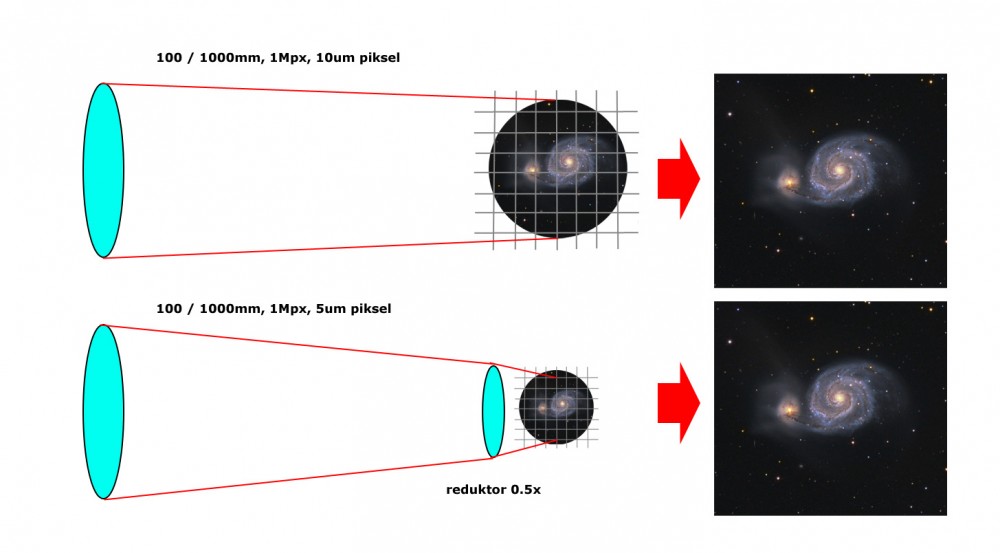

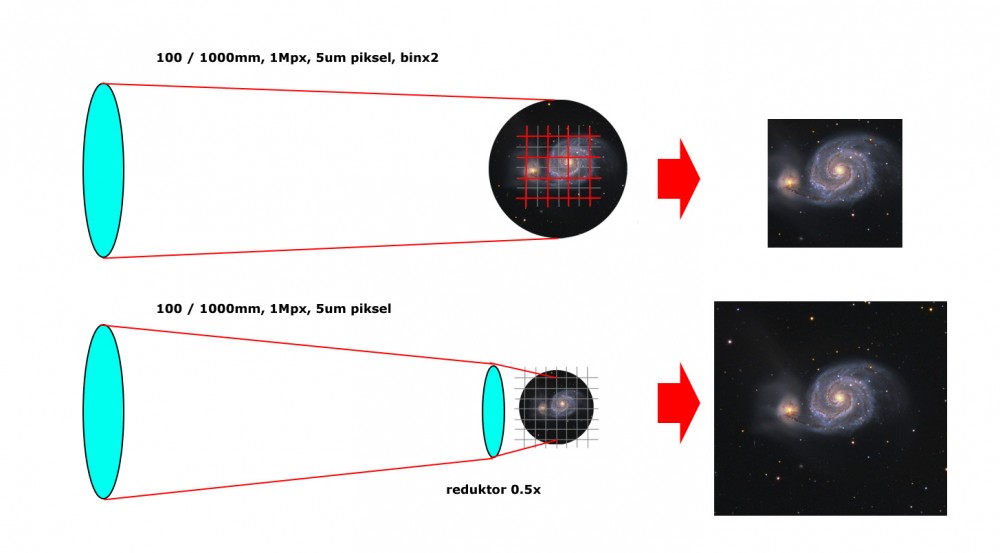

Skala zestawu (PDF do pobrania) Rozdzielczość zestawu (PDF do pobrania) Od fotonów do megabajtów (PDF do pobrania) Niewdzięczna rola kalibratora (PDF do pobrania) Montaż Kiedy zaczynałem przygodę z astrofotografią zacząłem się zastanawiać jak to wszystko działa i ze sobą współpracuje i czy na przykład mając dwa zestawy dające obraz o takiej samej skali otrzymamy taki sam obraz. Spędziłem trochę czasu na próbach zgłębienia zagadnienia, i jak to u mnie bywa, czasami najprostsze zagadnienia okazywały się być najtrudniejszymi do zrozumienia W tym krótkim tekście chciałbym się z Wami podzielić moimi (często zupełnie oczywistymi) spostrzeżeniami. Na potrzeby tych rozważań zakładam że opisywane matryce światłoczułe są takie same - mają taką samą sprawność i takie same szumy. Nie będę tutaj rozpatrywać różnic w parametrach sensora, a raczej jego pracę w kontekście całego zestawu. Podobnie zakładam, że opisywane instrumenty mają taką samą sprawność i jakość, ani nie będę wnikał w krzywizny pola, wady optyczne i takie tam Na początek weźmy na warsztat dwa zestawy o takiej samej skali obrazu. W obu mamy kamerkę z czipem o rozdzielczości 1000x1000px. pierwsza ma piksel o rozmiarze 10x10um i podłączona jest do instrumentu o aperturze 100 i ogniskowej 1000mm, czyli 100/1000 druga ma piksel o rozmiarze 5x5um i podłączona jest do teleskopu 50/500 Oba zestawy mają taką samą światłosiłę i dają obraz o takiej samej rozdzielczości 1Mpx i takiej samej skali równej około 2"/px. Czy otrzymane z nich zdjęcia będą takie same? Mogłoby się wydawać, że tak. Ale oba zestawy różnią się zasadniczym parametrem - aperturą. W astronomii to apertura rządzi, dlatego teleskopy są przede wszystkim duże, a nie światłosilne. Teleskop o aperturze 100mm zbierze cztery razy więcej fotonów, niż ten o aperturze 50mm, ponieważ ma cztery razy większą powierzchnię zbierającą światło. A ponieważ skala jest w obu zestawach taka sama [1], więc łatwo się domyślić, że każdy piksel kamerki z pierwszego zestawu zbierze cztery razy więcej sygnału, a co za tym idzie, otrzymany obraz będzie dużo lepszej jakości - stosunek sygnału do szumu będzie większy. Z tego prostego przykładu płynie kilka wniosków: po pierwsze z zestawu o większej aperturze w tym samym czasie zawsze uzyskamy lepszy obraz (ale patrz założenia na początku tekstu) połączenie teleskopu 100/1000 z kamerką o pikselu 10um da nam da nam taki sam rezultat, jak połączenie teleskopu 100/500 z kamerką o pikselu 5um. I będzie to wynik znacznie lepszy, niż połączenie teleskopu 50/500 z kamerką o pikselu 5um apertura jest najważniejsza, światłosiła to sprawa drugorzędna. W praktyce natomiast, szczególnie wśród amatorów, istnieje zapotrzebowanie na instrumenty światłosilne. Wynika to z tego, że jasny instrument będzie mniejszy i lżejszy, czyli bardziej poręczny i mniej wymagający dla montażu. Ale przede wszystkim zmniejszenie ogniskowej sprawia, że w celu uzyskania obrazu tej samej jakości możemy używać sensorów o mniejszych rozmiarach z mniejszym pikselem, które są po prostu dużo tańsze. Nie bez znaczenia jest też fakt, że większość amatorów astrofotografii uprawia astrofoto estetyczne, a w tej dziedzinie liczy się kadr, a nie konkretny obiekt. Światłosilne instrumenty mają oczywiście inne wady i są dość drogie, ale nie o tym ten tekst Hmhm, ale, ale - czy "połączenie teleskopu 100/1000 z kamerką o pikselu 10um da nam da nam taki sam rezultat, jak połączenie teleskopu 100/500 z kamerką o pikselu 5um" nie brzmi jak reduktor ogniskowej? Pewnie że tak. Kamerka o pikselu 10um da nam z dowolnym instrumentem identyczny obraz, jak kamerka o pikselu 5um podpięta do tego samego instrumentu przez reduktor ogniskowej o krotności 0.5x. Ale, ale, hmhm, czy "połączenie teleskopu 100/1000 z kamerką o pikselu 10um da nam da nam taki sam rezultat, jak połączenie teleskopu 100/500 z kamerką o pikselu 5um" nie brzmi również jak binning? Ponownie - jasne że tak. Binning to po prostu zwiększenie rozmiaru piksela - sygnał z określonej ilości sąsiadujących pikseli transferowany jest do jednego z nich i następnie sczytywany. Proces taki można przeprowadzić też programowo mając już obraz zapisany na dysku, ale z jedną różnicą - binning sprzętowy likwiduje nam część szumu odczytu, programowy tego nie robi. Binning sprzętowy to domena matryc CCD, współcześnie produkowane sensory CMOS nie pozwalają na stosowanie tego procesu i binning, o ile dostępny, wykonywany jest programowo przez sterownik kamerki. Czyli, podsumowując, kamerka o pikselu 5um w połączeniu z teleskopem 100/500 da nam obraz takiej samej jakości, jak ta sama kamerka pracująca w trybie binx2 z teleskopem 100/1000. Obraz obiektu będzie taki sam, natomiast kadr będzie inny, bo zmieni nam się pole widzenia zestawu. Kiedy w kamerce o natywnej rozdzielczości 1000x1000px zastosujemy binning 2x, to otrzymamy efektywną rozdzielczość 500x500px. Idąc za ciosem mamy jeszcze jeden wniosek - kamerka 5um podłączona do dowolnego teleskopu przez reduktor ogniskowej 0.5x da nam taki sam obraz obiektu, jak ta sama kamerka podpięta do tego samego teleskopu bez reduktora, ale pracująca w trybie binx2. Różnica będzie występowała tak jak poprzednio - w polu widzenia takiego zestawu. Tyle teorii, bo rzeczywistość jest o wiele bardziej prozaiczna. Ilość dostępnych dla amatorów modeli kamerek jest dość ograniczona. Nie doszukiwałem się jakiś statystyk, ale podejrzewam, że ponad 80% amatorskiego rynku pokryte będzie przez może dziesięć modeli matryc. Trzeba mieć świadomość, że nie ma zestawu uniwersalnego. Dlatego zanim się na któryś z nich zdecydujemy, warto sobie odpowiedzieć na kilka pytań krążących wokół jednego, głównego pytania - o cel naszych działań. Mając na celowniku astrofotografię estetyczną, kryteria są dość oczywiste - duże pole widzenia pozbawione wad i sporo pikseli, a rozmiar apertury schodzi na dalszy plan. Dzieje się tak, ponieważ w astrofotografii estetycznej interesuje nas kadr, a nie obiekt. Obiekt będzie nas interesował, kiedy główny ciężar naszych zainteresowań będzie przesunięty np w stronę fotometrii, poszukiwania gwiazd nowych i supernowych, zmiennych, nowych planetoid, czy spektrometrii. Wtedy pole manewru jest znacznie większe i warto powalczyć o sporą średnicę teleskopu, a zbyt dużą rozdzielczość zwalczyć binningiem, i/albo redukcją ogniskowej. No dobrze, a jaką skalę powinien mieć nasz zestaw? - o tym w następnej części [1] chodzi o skalę wyrażoną w "/px. Skala wyrażona w "/mm będzie oczywiście inna, ale przy rozważaniach tych konkretnych zestawów wyrażanie skali w "/mm ma mniejszy sens1 punkt

-

1 punkt

-

1 punkt

-

Decyzją Rady Forum Astronomicznego zmiany zostały zatwierdzone, ale od nowej edycji Konkursu dla Początkujących. Inaczej mówiąc, wszystkie osoby które NIE ZAJĘŁY dwóch pierwszych miejsc, spełniają inne warunki regulaminu i dostały status Złotego Uczestnika w 2019 roku mogą brać udział w konkursie od stycznia 2020. To już niedługo1 punkt

-

No to poszukaj innych ogniskowych - 35 mm to za dużo, 5 lub 6 za mało. Miałem kiedyś taką tubkę i sensowne okularki to okolice 10 -12 mm (źrenica wyjściowa ok. 2 mm) i 20-25 mm (źrenica 4-5 mm). Tego się trzymaj. To sprzęt do szerokich pól, taki trochę zamiennik lornetek.1 punkt

-

Moim zdaniem do Maka Lustrzany Dielektryk w zupełności wystarczy. Taką nasadkę można kupić za połowę ceny dobrego pryzmatu.1 punkt

-

Poniżej link do misji Apollo 11 :) prawie live https://apolloinrealtime.org/11/1 punkt

-

1 punkt

-

Niezapomniany pokaz: 50 lat po wylądowaniu ?The Museum of the Moon?, podróżująca praca brytyjskiego artysty Luke'a Jerrama, znanego na całym świecie, który odtworzyl wiernie powierzchie Księżyca na podstawie zdjec z NASA. Kula o srednicy 7m z najmniejszymi detalami ksiezyca.Zdjecia te nie maja tej magi co prawdziwy muniek ale na wielu ludziach robi efekt piorunujacy ,praca wykonana na 5 gdyby nie linie laczace na kuli byloby 6;)) Na ostatnim zdjeciu wylapalem Jowisza pomiedzy drzewami.??1 punkt

-

Dobrym pomysłem jest też rozejrzenie się, czy w okolicy nie mieszka jakaś dobra dusza z teleskopem. I pokaże jak niebo wyglądać może w dobrze ustawionym sprzęcie. Może być przecież tak, że faktycznie z Twoim sprzętem jest coś nie tak i się mocno zniechęcisz - a szkoda by było. (Chyba, że tak jak ja samym wystawieniem statywu na balkon przyciągasz chmury...)1 punkt

-

1 punkt

-

Dziś uwagi Łukasza Sochy "Jolo" - człowieka talentów wszelakich, naszego guru od sprzętu, astrofotografa z krajowej czołówki. Messier 20, Messier 8 Pierwsze co się rzuca w oczy w tym zdjęciu, to bogactwo kolorów i odcieni - zarówno w obszarach mgławicowych, ale też wśród gwiazd. Fotografia w nienachalny sposób pokazuje kilka oczywistych prawd o kosmosie: że większość gwiazd jest chłodnych, naprawdę niewiele jest na tyle gorących, żeby świeciły w błękicie, a kolor mgławic emisyjnych po przewędrowaniu tysięcy lat świetlnych przez materię międzygwiazdową wcale nie jest oczywisty. Fotografia jest dynamiczna i przestrzenna, a jednocześnie bardzo naturalna. Przy mocnym powiększeniu widać, że kształt gwiazd w narożnikach nie jest jednakowy, co może wskazywać na niewielką nieosiowość w torze optycznym, albo lekki brak kolimacji. Obrazy jasnych gwiazd (szczególnie położonych na tle mgławic) mają przepalone środki. Osobiście zwiększyłbym też nieco lokalny kontrast pomiędzy niektórymi obszarami na zdjęciu, ale jest to już kwestia mocno subiektywna, a zdjęcie mogłoby utracić naturalność. Daje się też zauważyć inny odcień ciemnych obszarów w narożnikach od tych położonych w centrum kadru. Może to być wina usuwania winiety, ale też może to być naturalna właściwość tych rejonów. Wszystkie te drobiazgi nie zmieniają jednak jednoznacznie pozytywnego odbioru tej fotografii, która dodatkowo prezentuje dość egzotyczne, choć osiągalne w krajowych warunkach obiekty. Ciemnotki Irysa Zdjęcie ukazuje w nieco szerszym ujęciu okolice znanej mgławicy Irys. W rejonie tym nagminnie występują obłoki materii międzygwiazdowej, których spora ilość zarejestrowała się na fotografii. Udało się pokazać pewne zróżnicowanie pomiędzy obszarami ciemnej materii, jak również pomiędzy jasnymi gwiazdami. Jednak spora część gwiazd jest dość monotonna i bezbarwna. Oczywiście pewna ilość gwiazd we Wszechświecie świeci w barwie białej (czego najlepszym przykładem jest Słońce), ale na zdjęciach powinno się dać uwypuklić kolor gwiazd i jego różnice pomiędzy obiektami. Na pewno pomogłaby większa ilość materiału, a może też i lepsza jakość nieba (w opisie fotografii nie podano warunków, w jakich została zrobiona). Zanieczyszczenie światłem nocnego nieba niestety mocno utrudnia późniejsze zbalansowanie kolorów w fotografii wykonanej przez filtry LRGB albo kamerą kolorową. Niemniej jednak zdjęcie jest jak najbardziej poprawne, nie jest przesadnie odszumione, a ukazanie w interesujący sposób ubogiego w szlagiery obszaru nieba zawsze będzie wyzwaniem. Zdjęcie ?Ciemnotki Irysa? w dużej części temu wyzwaniu sprostało. NGC 7635 Jeden z najpopularniejszych obiektów pokazany został w niecodziennej kolorystyce. Zdjęcie wykonane zostało w technice bicolor - materiał został zebrany dla pasm H alpha oraz Oiii, a następnie zmapowany na kolory z palety RGB. W obrębie samego ?bąbla? oraz w najbliższym otoczeniu zostały starannie ukazane detale obłoków gazu i fragment ten jest wyrazisty i plastyczny. Również syntetyczny kolor gwiazd jest przyjemny dla oka, choć wokół mniejszych gwiazdek widoczne są niewielkie obwódki, które powstały najprawdopodobniej podczas obróbki. Pomimo sporej ilości klatek (w sumie według opisu ponad 28 godzin) zewnętrzne, słabsze obszary mgławicy są słabo wyeksponowane, a stosunek sygnału do szumu jest niewielki. Fakt ten może wynikać z kilku powodów. Pierwszym z nich może być skromna 80mm apertura użytego instrumentu, choć jest sporo zdjęć tego obszaru wykonanych przez mniejsze 71 lub 65mm refraktory. Innym powodem mogą być niekorzystne warunki podczas akwizycji materiału (Księżyc, światła miejskie), które przeszkadzają nawet przy stosowaniu filtrów wąskopasmowych. Jeszcze innym powodem może być niedopasowanie wzmocnienia kamerki (przy teleskopie f/6.5, czasach klatki 5 minut i filtrach wąskopasmowych warto zwiększyć gain do okolic wzmocnienia jednostkowego). Kolejnym powodem może być nieprawidłowo wykonana kalibracja. Może warto jeszcze raz spróbować sił z tym materiałem, bo przy 28 godzinach ekspozycji powinno się udać wydobyć więcej.1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

Również z przypadkowo z telefonu, 14-06-2019 i kwietniowa pełnia aż nie chce się wyciągać sprzętu z takim aparatem w kieszeni1 punkt

-

Zdjęcia nie planowane aparatem z tel. komórkowegoi pytanie: 12-06-2019 17-06-2019 Księżyc i u góry po prawej Jowisz Jowisz ze zdjęcia powyżej w zbliżeniu - czy to możliwe, że ta kropka pod nim to jeden z jego księżycy? Bo nie dowierzam, by smartfon mógł to uchwycić ?1 punkt

-

1 punkt

-

1 punkt

-

1 punkt

-

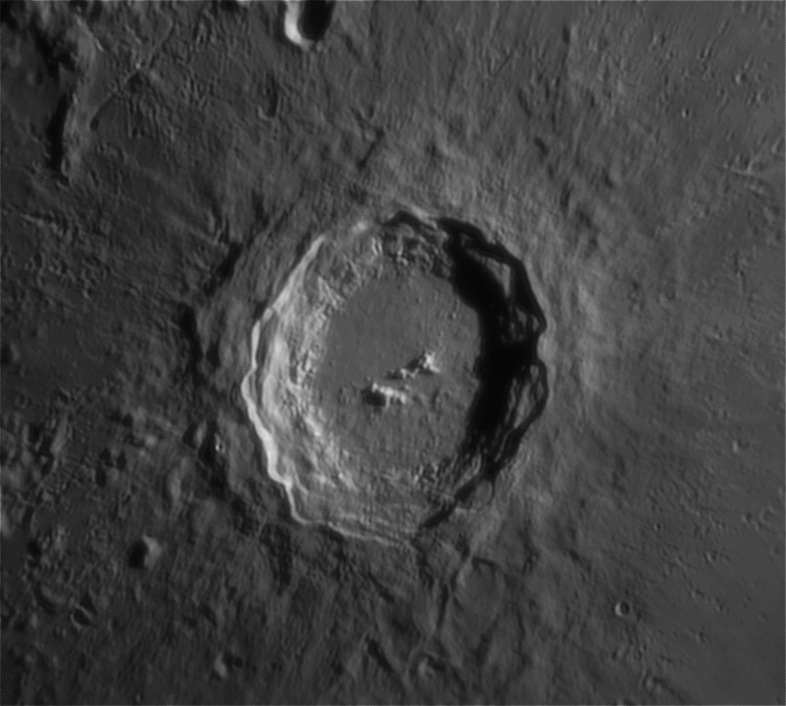

Tak się składa, że kolejne Obiekty Tygodnia stają się coraz trudniejsze. Czyżby łatwiejsze cele obserwacyjne się wyczerpały? Niekoniecznie, nieboskłon jest tak bogaty, że zawsze da się znaleźć coś ciekawego i niekoniecznie trudnego. Zresztą, trudność to pojęcie względne ? zależy i od umiejętności obserwatora, i od sprzętu, od warunków, no i jeszcze od samej dogłębności obserwacji. Wydaje mi się, że znalazłem obiekt, który zadowoli jeśli nie wszystkich, to wielu astroamatorów, także w te nadchodzące majowo-czerwcowe białe noce. Dosłownie każdy widział dyszel Wielkiego Wozu z jego charakterystycznym przegięciem (w naturze takie dyszle nie występują). W zgięciu znajduje się gwiazda oznaczona przez Bayera Zeta Wielkiej Niedźwiedzicy (? UMa). Wielki Wóz (Sky-Map.org) Jednak nawet gołym okiem, nawet w marnych warunkach obserwacyjnych da się wypatrzyć, że jest tam także druga, słabsza gwiazda. Ma jasność 4 mag i nosi nazwę Alkor (inaczej 80 UMa). Według Wikipedii nazwa ta pochodzi z arabskiego i oznacza czarnego konia. Stąd już blisko do tego, by parę Mizar-Alkor nazwać Koniem i Jeźdźcem. Dzieli je niemal 12 minut kątowych, więc nie trzeba nadzwyczajnego wzroku, by obie widzieć bez jakiegokolwiek sprzętu. Niewielka lornetka pozwoli dostrzec pomiędzy nimi trzecią, jeszcze słabszą gwiazdkę (7,6 mag) tworzącą z Mizarem i Alkorem nieco rozwarty trójkąt. Wbrew oczekiwaniom, nadano jej nazwę własną. Bodajże drugi jej obserwator, którego nazwisko zostało zapomniane, nazwał ją Sidus Ludoviciana (Gwiazda Ludwika) na cześć swojego protektora landgrafa Hesji. Źródło: http://dosiegnacgwiazd1.blogspot.com/2017/06/mizar-i-alkor-ukad-szesciokrotny.html Jeśli jednak dysponujemy lornetką o powiększeniu 20 razy, sprawa zaczyna być jeszcze ciekawsza. Z łatwością dostrzeżemy, że sam Mizar zawiera dwa składniki. Źródło: https://www.cloudynights.com/topic/428082-mizar-alcor/ Jaśniejszy z nich, Mizar A ma jasność 2,3 mag, słabszy podobnie jak Alkor ma 4 mag. Wszystkie te gwiazdy są zbliżonego typu widmowego A, można więc powiedzieć, że są białe. Obserwowałem je ostatnio niemal w zenicie, więc jeszcze przez lornetę kątową 45° na statywie dawało mi się jakoś patrzeć. Spróbowałem także przez prostą lornetkę 15x56, jednak postawa była na tyle niekomfortowa, że rozdziału składników Mizara nie dostrzegłem. Zapewne jest to jednak możliwe przy powiększeniach 15-16x dla obserwatora dysponującego dobrym wzrokiem i żurawiem lornetkowym oraz rozkładanym fotelem umożliwiającym komfortowe patrzenie w zenit. Mniejszym powiększeniom raczej nie daję szans czystego rozdziału, choć dobra optycznie lornetka 12x może ukazać nieco rozciągnięty kształt gwiazdy, wskazujący na podwójność. Mizar był pierwszym rozdzielonym teleskopowo układem, był także pierwszym układem sfotografowanym. Jednak to jeszcze nie wszystko. Gdy rozpoczęto badania spektroskopowe światła gwiazd, okazało się, że widma jego składników są jakieś dziwne. Już w 1889 r. Pickering stwierdził, że Mizar A jest w rzeczywistości układem podwójnym. Był to więc pierwszy układ podwójny odkryty spektroskopowo (za The Photographic Atlas of the Stars (HJP. Arnold, P. Dorothy, P. Moore). To samo wykryto wkrótce dla Mizara B ? też jest ciasnym układem podwójnym. Sam Mizar jest więc układem poczwórnym. Jednak po wielu dyskusjach przyjmuje się obecnie, że Mizar i Alkor, pomimo znacznej odległości kątowej na nieboskłonie są związane grawitacyjnie i krążą wokół wspólnego środka ciężkości z okresem obiegu, bagatela, 750 tysięcy lat. Gwiazda tworząca z nimi wspomniany wcześniej trójkąt jest jednak niezwiązaną gwiazdą tła. Jeśli dodamy do tego niedawne odkrycie podwójności samego Alkora, będziemy mieć całkiem egzotyczny układ sześciokrotny. I cóż nam się zrobiło z banalnego, w dodatku krzywego dyszla czy też niedźwiedziego ogona? Pędźmy więc pod wieczorne niebo, choćby zaświetlone i niekoniecznie czyste, z naszym sprzętem lub nawet bez niego. Popatrzmy na banalną niebanalną gwiazdę ? UMa a następnie jak zwykle dajmy znać, jak poszło.1 punkt

-

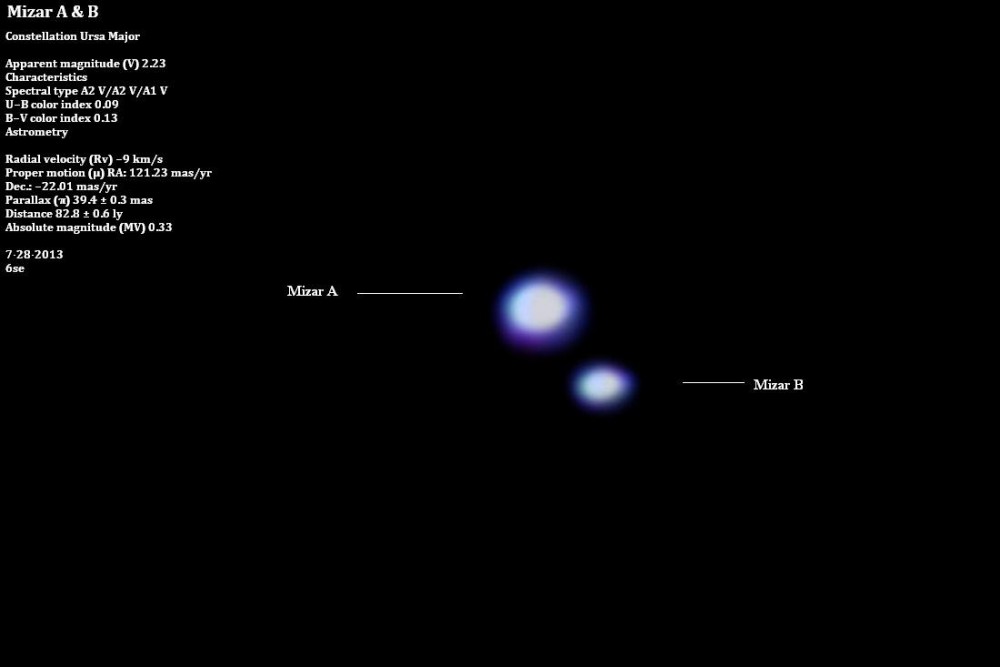

Szef NASA ostrzega przed asteroidami 2019-05-02 Zagrożenie ze strony asteroid jest realne. Potwierdził to niedawno szef NASA, Jim Bridenstine. Jim Bridestine, szef NASA, wygłosił przemówienie otwierające Konferencję Obrony Planetarnej 2019. Powiedział, że zagrożenie ze strony asteroid i innych kosmicznych obiektów jest realne. Bridestine posłużył się przykładem wydarzenia w Czelabińsku, kiedy 20-metrowy obiekt NEO wszedł do atmosfery i eksplodował nad Rosją. Wywołało to falę uderzeniową, która uszkodziła ponad 7000 budynków. Chciałbym powiedzieć, że te wydarzenia są wyjątkowe... ale nie są. Musimy upewnić się, że ludzie rozumieją, że nie chodzi o Hollywood, nie chodzi o filmy. Chodzi o ostateczną ochronę jedynej planety, która nadaje się do życia - naszej planety - powiedział Bridestine. Szef NASA wspomniał także o wyzwaniach naukowych i technicznych, z którymi musimy się zmierzyć, jeżeli chodzi o potencjalne zagrożenia. - Jesteśmy zaledwie w 1/3 drogi, a obowiązujące prawo mówi, że NASA musi być w stanie wykryć, śledzić i scharakteryzować nie 1/3, a 90 proc. NEO. To oznacza, że musimy korzystać z naszych systemów i wszystkich możliwości, które pozwolą zebrać dużo więcej danych. Chcemy więcej międzynarodowych partnerów, którzy dołączą do nas w tym wysiłku - dodał Bridestine. Aby móc wychwycić obiekty tak małe, jak bolid z Czelabińsku, potrzebujemy obserwatorium kosmicznego, takiego jak kamera NEOCam. Niestety, na finalizację projektu nie ma na razie finansowania. Szacuje się, że do tej pory odkryto ok. 50 proc. wszystkich NEO o średnicy większej niż 140 m, ale mniejszej niż 1 km. Jeżeli jeden z nich uderzyłby w Ziemię, mógłby doprowadzić do poważnych zniszczeń w skali całego kontynentu. https://nt.interia.pl/raporty/raport-kosmos/ziemia/news-szef-nasa-ostrzega-przed-asteroidami,nId,29673761 punkt

-

Koniec świata za każdym razem gdy mija nas asteroida? Portale kpią z odbiorców. 2019-05-02. Piot Większe i mniejsze polskie portale internetowe coraz częściej w tytułach aktualności lubią głosić wieści o końcu świata. Wyłowiliśmy dla Was tylko kilka z całej masy takich tytułów - "Asteroida 2002 NT7 uderzy w Ziemię. Koniec świata będzie w 2019?", "Koniec świata 13.01.2019 - asteroida 2002 NT7 'realnym zagrożeniem", :Asteroida 2002 NT7 uderzy w Ziemię i spowoduje koniec świata w lutym 2019 r.? Amerykańscy naukowcy alarmują i ostrzegają". To tylko kilka przykładów, które spowodowały, że ogarnął nas śmiech. W tym tygodniu sieć obiegły kolejne wieści sugerujące, że "NASA szykuje się na uderzenie asteroidy". Inny portal poszedł dalej tytułując aktualność w ten oto sposób - "NASA jest przerażona! Naukowcy szykują się na uderzenie astreroidy w Ziemię!" Postanowiliśmy zrobić to po swojemu, czyli zgodnie ze stanem faktycznym opisać Wam krótko przelot wyżej przywoływanej asteroidy, a ponadto pośmiać się z najnowszych tytułów, dementując przy okazji herezje głoszone przez niektóre portale. Nie da się ukryć ? powyższe tytuły mają na celu przyciągnąć do wnętrza aktualności jak największą liczbę odbiorców. Niestety stosowany na wielu portalach zabieg wciąż jest skuteczny skoro tak chętnie stawiają na niego autorzy. My jako portal Astronomia24 staramy się rzetelnie informować Was o szeregu doniesień. Czas więc tym razem przyjrzeć się asteroidzie 2002NT, która zdaniem części portali nie tak dawno - miała uderzyć w Ziemię. Asteroida 2002 NT to obiekt z grupy Apolla o średnicy bliskiej 1,5 km, którego odkrycia dokonano w lipcu 2002 roku. 2002 NT7 została sklasyfikowana jako obiekt bliski Ziemi i potencjalnie niebezpieczny. Nie musi to jednak oznaczać bezpośredniego zagrożenia dla naszej planety. Według wstępnych obliczeń orbity uznano, że asteroida znajduje się na kursie kolizyjnym z Ziemią. Tu kluczowe jest słowo ? wstępnych, bowiem w wyniku standardowych dalszych analiz stwierdzono, iż obiekt minie Ziemię w odległości około 61 mln km? Wskazać wypada, że do takich wniosków udało się dojść już w sierpniu 2002 roku, czyli miesiąc po odkryciu obiektu. Tym samym 2002 NT7 usunięto z listy obiektów o wysokim ryzyku zderzenia z Ziemią. To jednak nie przeszkodziło portalom w stworzeniu sensacyjnych tytułów. Wy - miłośnicy astronomii odwiedzający nasz portal macie świadomość, że tego typu treści pojawiające się w sieci nie leżały obok prawdy, czy nawet półprawdy. Niestety wielu odbiorców, którzy nie śledzą na co dzień wieści ze świata astronomii często odczuwają lęk już po przeczytaniu samego kłamliwego tytułu zapowiadającego na przykład uderzenie asteroidy w powierzchnię naszej planety. Nie ukrywajmy - często dostajemy wiadomości z zapytaniami o tego typu doniesieniach trafiających na portale. Cieszymy się, że zazwyczaj pełnimy rolę strony uspokajającej. Niestety nie każdego jesteśmy w stanie uświadomić, bo po prostu... nie do każdego jesteśmy w stanie dotrzeć z prawdziwym przekazem. Bulwersuje nas to, że autorzy zatrudnieni na portalach posuwają się do tak nieczystych zagrań. Publikowanie treści mijających się z prawdą, przy okazji siejących panikę i straszących odbiorców to nie dziennikarstwo, a najniższych lotów parodia tej dziedziny. Stanowczo mówimy NIE kłamliwym doniesieniom i zamierzamy piętnować je na łamach naszego portalu. Ręce opadają nam za każdym razem, gdy czytamy tytuły takie jak te przywołane wyżej, bowiem mamy świadomość tego, jak wielu odbiorców uznaje je za jedyną słuszną prawdę. Co warto podkreślić - niemal przed każdym przelotem większej, a nawet stosunkowo małej asteroidy mamy do czynienia z tą samą narracją portali ? "koniec świata", "prawdopodobnie uderzy w Ziemię", "NASA jest przerażona"... Tymczasem zachęcamy Was do pozostania z naszym portalem i śledzenia prawdziwych doniesień. Źródło: astronomia24.com https://www.astronomia24.com/news.php?readmore=8751 punkt

-

Wczoraj pojawiło się kilkugodzinne okienko na obserwacje. Udało mi się skompletować 4 osoby na mały wypad. Mieliśmy do dyspozycji Synte 8" i 3 lornetki: 8x42, 10x50, 20x80. Może warunki nie były idealne, ale dzięki temu już wiem w jakim kierunku chce iść. Na pewno nie jest to Synta 8". Duże powiększenia po raz kompletnie mnie nie poruszyły, nie poczułem żadnego wow, czy też nawet chęci ponownego spojrzenia. Większą radość sprawiało mi spoglądanie przez 10x50. M31 podobała mi się bardziej w prostej lornetce Celestron 20x80 niż w Syncie. W chwili obecnej zastanawiam się, czy spoglądanie przez jedno oko jest w ogóle dla mnie. Bardziej mnie to denerwowało niż dawało radość. Dam sobie jeszcze trochę czasu, ale jeśli przy 3 próbie będę miał takie same wnioski to wracam do pierwotnej decyzji - idę w lornetki Zdałem sobie też sprawę, że obserwacje Syntą wymagają sporo czasu. Wyskok na 2-3h to kiepski pomysł. Pakowanie, rozstawianie, chłodzenie, szukanie na niebie. Tutaj potrzeba więcej czasu na komfortowe obserwacje. To kolejna ważna dla mnie kwestia, bo takich dłuższych obserwacji w roku byłoby może... kilka. Brak czasu, pogody i inne czynniki. Muszę szukać sprzętu pod siebie, a nie polecanego przez innych1 punkt

-

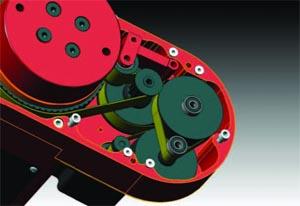

Montaż Nie będzie przesadą powiedzenie, że wybór montaży na amatorskim rynku astronomicznym jest ogromny. Nie będzie też odkryciem stwierdzenie, że ceny montaży są wysokie. Montaż to jednak ciężki kawał mechaniki precyzyjnej i jednocześnie zdolnej do poruszania dużych ciężarów. Z punktu widzenia amatora astrofotografii montaże można podzielić na dwie grupy: paralaktyczne (gdzie jedna z osi obrotu jest równoległa do osi obrotu Ziemi), oraz azymutalne (gdzie jedna z osi obrotu jest pionowa). Montaże azymutalne doskonale sprawdzają się w obserwacjach wizualnych, ale ze względu na rotację pola w astrofotografii ich zastosowanie jest ograniczone do krótkich czasów ekspozycji. Niektóre firmy oferują urządzenia niwelujące efekt rotacji pola, ale jest to rozwiązanie mało popularne. Są też montaże, które możemy jednocześnie umieścić w obu tych grupach - jak na przykład montaże Sky Watcher AZ-EQ, iOptron Pro Dual, czy montaże widłowe, w których z trybu azymutalnego możemy przełączyć się w tryb paralaktyczny po zamontowaniu tak zwanego klina paralaktycznego. Jeszcze jedną odmianą montażu paralaktycznego są platformy paralaktyczne, na których możemy umieścić teleskop na montażu dobsona, co umożliwi robienie takim zestawem zdjęć. Z punktu widzenia amatora astrofotografii najważniejszą rzeczą jest to, żeby montaż potrafił śledzić ruch obiektów na niebie wynikający z ruchu obrotowego Ziemi. W ten sposób możemy wykonywać zdjęcia obiektów astronomicznych z długimi czasami naświetlania. Jak długie czasy będziemy mogli stosować - to już zależy od dokładności ustawienia oraz prowadzenia montażu. Ale o tym trochę później. Montaż do uprawiania astrofotografii powinien być wyposażony w napęd przynajmniej w jednej osi, który będzie tą osią poruszał z szybkością równą szybkości obrotowej Ziemi. Kiedyś takimi napędami były mechaniczne urządzenia zegarowe. Obecnie są to już wyłącznie różnego rodzaju silniki elektryczne, najczęściej prądu stałego albo krokowe. Silnik taki napędza jedną albo obie osie teleskopu najczęściej z użyciem dodatkowej przekładni, ale nie zawsze - na przykład w montażach ASA Direct Drive silnik napędza osie bezpośrednio. Wśród przekładni z kolei w montażach amatorskich najczęściej spotykane są przekładnie ślimakowe. Ślimacznica z dużą ilością zębów umieszczona jest na każdej osi i napędzana przez ślimak. Ślimak z kolei napędzany może być bezpośrednio silnikiem krokowym (jest tak na przykład w osi deklinacji montażu Sky Watcher EQ8), albo przez dodatkową przekładnię zębatą lub paskową. Innym rodzajem przekładni jest przekładnia cierna. Ten rodzaj przełożenia jest szczególnie chętnie stosowany w konstrukcjach ATMowych ze względu na prostotę wykonania. Wadą takiej przekładni jest ryzyko występowania uślizgów pomiędzy kołami przekładni. Kolejnym rodzajem przekładni stosowanym coraz chętniej przez producentów są przekładnie z paskami zębatymi. Przekładnie takie mogą współpracować z przekładnią ślimakową (np w montażach Sky Watcher EQ6-R czy AZ-EQ5), ale istnieją też konstrukcje oparte wyłącznie na paskach zębatych (np Avalon Instruments Linear). Zaletami takiej przekładni jest cicha praca i brak luzów. Wadą jest nieco większa ilość miejsca, którą taka przekładnia zajmuje. Rodzaj i jakość wykonania przekładni wpływa bezpośrednio na dokładność prowadzenia montażu. Więcej o tym w dalszej części wpisu. Żeby montaż trafiał w wybrany punkt na niebie i potrafił go dokładnie śledzić, musi znać swoje położenie. Znakomita większość amatorskich montaży opiera się na metodzie względnej określania swojego położenia. W praktyce oznacza to, że po uruchomieniu montaż musi zostać skalibrowany. Część montaży posiada funkcję automatycznego znajdowania pozycji startowej (np Sky Watcher EQ8, iOptron CEM120 czy Celestron CGX), ale większość po uruchomieniu wymaga ręcznego ustawienia pozycji z której montaż będzie startował. Kolejną czynnością do wykonania będzie kalibracja montażu, czyli ustawienie go na pewną ilość znanych punktów na niebie (np jasnych gwiazd) i skorelowanie obliczonego położenia z rzeczywistym. Z kolei teoretyczne położenie montażu określane może być w różny sposób. Najprostszą metodą jest użycie silników krokowych i po prostu zliczanie kroków. Zakładamy wtedy, że silnik nie gubi kroków i przesunięcie go o określoną ilość kroków zawsze będzie skutkowało obrotem montażu o taki sam kąt. Jest to wygodny i wiarygodny sposób, o ile silnik krokowy nie jest uszkodzony albo przeciążony. Silniki krokowe są szeroko stosowane na przykład w montażach Sky Watcher. W przypadku stosowania silników prądu stałego konieczne jest zastosowanie dodatkowych enkoderów na osi silnika, dzięki którym możemy określić położenie i obrót takiego silnika. Rozwiązanie to stosują w swoich montażach np firmy Celestron oraz iOptron. Czasami w osiach montażu stosowane są dodatkowe enkodery mierzące bezpośrednio położenie montażu. Enkodery takie mogą być niskiej albo wysokiej rozdzielczości. Te pierwsze zapewniają pomiar położenia z dokładnością rzędu jednej minuty kątowej i używane są do określania położenia montażu. Enkodery wysokiej rozdzielczości zapewniają rozdzielczość na poziomie ułamka sekundy kątowej i mogą być używane zarówno do określenia położenia montażu, ale także do pomiaru i korygowania na bieżąco szybkości obrotowej osi montażu w czasie śledzenia. Pomaga to wyeliminować sporą część błędów prowadzenia z błędem okresowym na czele. Rozwiązanie takie stosowane może być w połączeniu z różnymi rodzajami przekładni i można je spotkać na przykład w montażach ASA, iOptron czy Astro Physics, a także jako dodatkowe moduły do innych popularnych montaży (Telescope Drive Master). Kolejną ważną cechą charakteryzującą montaż jest jego nośność. W przypadku astrofotografii amatorskiej możemy się spotkać z bardzo szerokim przedziałem tej wielkości. Z jednej strony mamy sporo miniaturowych urządzeń, na których możemy zamontować aparat z obiektywem (iOptron SkyTracker, Baader Nanotracker, Star Adventurer). Z kolei górna granica praktycznie nie istnieje i ograniczona jest głównie budżetem. Nośność montażu podawana przez producenta to oczywiście wartość umowna. Jeśli podawana nośność montażu wynosi np 20kg, to nie oznacza, że zestaw o masie 19kg będzie działał bardzo dobrze, a o masie 21kg przestanie działać. Druga sprawa to zaufanie do specyfikacji producenta. Przykładowo posiadacze montaży Sky Watcher doskonale wiedzą, że obciążenie ich na granicy nośności nie pozwoli na uzyskanie zadowalających wyników w astrofotografii. Z kolei obciążenie montaży Paramount czy Takahashi na granicy ich nośności wciąż będzie owocowało poprawnym zachowaniem. Kolejną rzeczą do przemyślenia jest rodzaj obciążenia. Refraktor o długości 1.5m ważący 15kg będzie dużo gorzej współpracował z montażem, niż na przykład kompaktowy teleskop RC ważący tyle samo, ale o długości 0.5m. Będzie to widoczne szczególnie wyraźnie, kiedy zacznie wiać wiatr. W szczególnych przypadkach duży, ale lekki teleskop (np 8" newton) może sprawiać większe kłopoty niż mniejszy, ale cięższy instrument (np 120mm tryplet apochromatyczny). Nośności podawanej przez producenta nie należy przekraczać ponieważ montaż może ulec uszkodzeniu mechanicznemu, a poza tym nie stosując się do specyfikacji tracimy gwarancję. Ale z drugiej strony samo nie przekraczanie nośności montażu nie gwarantuje nam poprawnej pracy zestawu. To już trzeba będzie sprawdzić samemu. No i na koniec cecha montażu, która bezpośrednio wpływa na jakość otrzymywanych zdjęć, czyli dokładność prowadzenia montażu. Wpływa na nią wiele czynników. Część z nich wynika z sposobu użytkowania urządzenia: rodzaj obciążenia, warunki (temperatura, wiatr), dokładność ustawienia na biegun. Ale część z tych czynników wynika z budowy samego montażu. Bardzo istotną rzeczą jest sztywność konstrukcji urządzenia. Montaż którego konstrukcja nie zapewnia dużej sztywności i szybkiego tłumienia drgań, będzie szczególnie źle sprawował się podczas pracy przy wiejącym wietrze. Oprócz sztywności montażu na dokładność prowadzenia ogromny wpływ ma rodzaj, ale przede wszystkim jakość wykonania przekładni montażu. Sam silnik (czy to krokowy, czy prądu stałego z dodatkowym enkoderem) najczęściej sterowany jest z dużą dokładnością i nie jest źródłem błędów prowadzenia. Błędy prowadzenia będą powstawały na przekładniach. Każda przekładnia ślimakowa czy zębata przede wszystkim charakteryzuje się pewnym luzem. Gdyby nie było luzu, przekładnia nie mogłaby działać. Luz sam w sobie nie jest źródłem błędu prowadzenia montażu, dopóki przekładnia nie zmieni kierunku obrotu. W przypadku osi RA taka sytuacja nie ma miejsca, ponieważ w czasie śledzenia oś ta zawsze obraca się w jedną stronę. Jedynie szybkość obrotu osi RA może się zmieniać, kiedy używamy autoguidingu. W przypadku osi Dec taka sytuacja może mieć miejsce jedynie wtedy, kiedy używamy autoguidingu. Ale w praktyce zawsze występuje pewna niedokładność w ustawieniu montażu na biegun, a to z kolei sprawia, że korekty w osi Dec będą wtedy wykonywane zawsze w jednym kierunku. Tak wygląda sytuacja, kiedy otoczenie nie wpływa na montaż. Jednak kiedy nasz montaż posiada pewien luz w jednej lub obu osiach i zaczyna wiać wiatr, może on powodować ruchy teleskopu i montażu w zakresie występującego luzu. Zapobiegać temu możemy przez wyregulowanie luzów do minimalnej wartości, kiedy jeszcze przekładnia nie stawia oporu, a także przez niewielkie zaburzenie równowagi podczas balansowania zestawu. W ten sposób zestaw będzie dążył do pracy tylko po jednej ze stron luzu i jego efekt będzie mniej widoczny. Kolejnym czynnikiem wpływającym na dokładność prowadzenia teleskopu jest jakość wykonania przekładni. Niedokładność wykonania może się objawiać w co najmniej dwóch zjawiskach. Pierwszym z nich jest tak zwany błąd okresowy przekładni - głównie ślimakowej, ale także zębatej czy ciernej. Błąd ten wynika z niedokładnego wykonania elementów przekładni, a jego efektem jest powtarzająca się niedokładność w szybkości prowadzenia montażu. Okres powtarzania się tej niedokładności równy jest obrotowi jednego z elementów przekładni. Przykładowe błędy okresowe (ang. periodic error) mogą wynosić od nawet +- 60" dla małych montaży napędzających lustrzanki z obiektywem, przez +-10-30" dla montaży klasy EQ6 czy HEQ5, aż do wielkości rzędu pojedynczych sekund kątowych dla montaży z dobrej jakości przekładniami (np Paramount MyT czy iOptron CEM120). Podstawowym sposobem eliminacji błędu okresowego jest jego kompensacja. Spora część montaży amatorskich umożliwia wgranie do montażu krzywej korygującej błąd okresowy (ang. Permanent Periodic Error Correction, PPEC), albo też wgranie jej do sterownika montażu (np VS-PEC w przypadku EQASCOM). Innym sposobem na pozbycie się błędu okresowego jest zastosowanie dodatkowych enkoderów wysokiej rozdzielczości umieszczonych w osiach montażu. Enkodery te monitorują na bieżąco szybkość obrotu osi i utrzymują ją na stałym poziomie. Rozwiązanie takie stosowane jest np w montażach ASA DDM, a także dostępne jest jako dodatkowa opcja np w niektórych montażach iOptron czy Astro Physics. W przypadku kiedy montaż nie oferuje nam żadnego z tych sposobów, pozostaje jedynie autoguiding. Należy tutaj pamiętać, że autoguiding nie zastąpi korekcji błędu okresowego. Zasadnicza różnica jest taka, że autoguiding koryguje tylko te błędy, które już nastąpiły. A z kolei PPEC czy VS-PEC zapobiega powstawaniu błędu okresowego zanim on nastąpi. Najlepsze wyniki zazwyczaj daje połączenie niezależnie działającej korekcji błędu okresowego z autoguidingiem. Niedokładność wykonania przekładni może również dotyczyć stykających się powierzchni przekładni. Drobne nierówności na tych powierzchniach, złe smarowanie albo zanieczyszczenia będą powodowały drobne i szybkie błędy prowadzenia montażu. Błędy te będą chaotyczne i na tyle szybkie, że nie jest możliwe wyeliminowanie ich za pomocą autoguidingu. Ponieważ nie są okresowe, więc również krzywa PEC nic tu nie pomoże. A z kolei dodatkowe enkodery o dużej rozdzielczości będą w stanie wyeliminować tylko część z nich. Dlatego dokładność wykonania precyzyjnych elementów montażu jest tak istotna. Na końcowy efekt w postaci zdjęcia obiektu astronomicznego oprócz prowadzenia montażu wpływ mają również (czasami największy) warunki atmosferyczne, a w szczególności seeing. W naszym krajowym klimacie seeing średnio wynosi około 2.5" i rzadko schodzi poniżej 2" (w przypadku fotografii z czasami dłuższymi niż kilka sekund). Dlatego różnica w zdjęciach wykonanych z montaży, które zapewniają dokładność prowadzenia odpowiednio 0.5" i 0.1" będzie znikoma. Byłaby ona dużo wyraźniejsza podczas fotografowania z miejscówek ze znacznie lepszym seeingiem.1 punkt

-

1 punkt

-

1 punkt

-

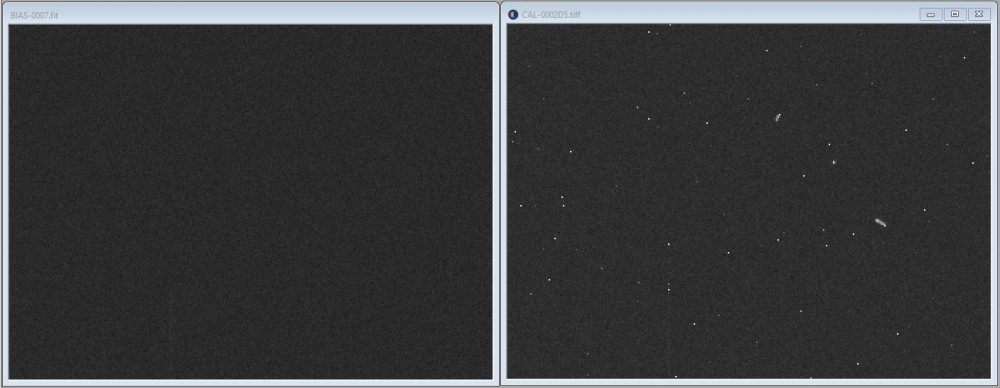

Niewdzięczna rola kalibratora Od ostatniego tekstu o działaniu kamerek wiało grozą i ujemnym poczuciem humoru, a przy okazji jego ciężar gatunkowy był w stanie unicestwiać gwiazdy neutronowe. Tym razem nieco lżej o kalibracji. Czy kalibracja jest niezbędna? A) Nie. Znam przynajmniej kilku astrofotografów, którzy długo nie kalibrowali, albo wciąż nie kalibrują swojego materiału, a efekty ich pracy łapią się bez problemu w okolicach wskaźnika "opad szczęki z łomotem", a przy okazji są w pełni powtarzalne. Jakie są zalety nie kalibrowania? Nie marnujemy czasu na tworzenie i utrzymanie biblioteki klatek kalibracyjnych, podczas obróbki również oszczędzamy trochę czasu i nie wprowadzamy do materiału szumu kalibracyjnego. W zamian musimy usuwać hot piksele programowo albo stosować dithering, utrzymywać nasze szkło w czystości (tak czy siak powinniśmy), a podczas obróbki trzeba programowo usuwać winietę i kleksy ze zdjęć (tak jakbyśmy jeszcze mieli mało do poprawiania). B) Tak. Kiedy estetyka zdjęcia nie jest jedynym celem uprawiania astrofotohobby, wtedy kalibracja jest konieczna. I powinna być zrobiona prawidłowo. Ale to nie jest trudne, bo to proces w pełni przewidywalny i automatyczny. Do czego kalibracja nie służy? Nie służy do redukcji ani tym bardziej do usuwania szumu ze zdjęć. No dobra, chyba że się umówimy, że hot piksele to szum - wtedy tak. Ale hot piksele to nie jest szum, więc jednak nie. Nie usunie nam też gradientów wynikających z nierównomiernie oświetlonego nieba. Nie służy też do niczego, jeśli klatki kalibracyjne są nieaktualne, albo nieprawidłowo używane. Do czego kalibracja służy? Do usuwania powtarzalnych artefaktów ze zdjęć. Klatki kalibracyjne BIAS usuwają gradient wynikający z nierównomiernej dystrybucji offsetu na matrycę, oraz padnięte kolumny. Klatki DARK usuwają efekty nierównomiernego chłodzenia matrycy (np. amp glow), hot piksele, i inne artefakty związane głównie z przepływem prądu termicznego. Klatki FLAT usuną winietę układu optycznego i kleksy powstałe na zabrudzeniach na matrycy, filtrach i innych elementach toru optycznego. Jakie są efekty uboczne kalibracji? Wprowadza do materiału szum kalibracyjny. Że co? Wprowadza dodatkowy szum. Naszym zadaniem, jako kalibratora, jest ten szum zminimalizować. Dlatego do kalibracji nie używamy pojedynczych klatek, tylko składamy ich wiele. Jakbyśmy tego nie robili, mielibyśmy taki efekt (kalibrowana była jedna klatka z materiałem Ha, ekspozycja 600s, kamera Atik 383, tsensor=-20*C): ILOŚĆ KLATEK KALIBRACYJNYCH SZUM KALIBROWANEJ KLATKI [ADU] KLATKA SUROWA 34.9 1 BIAS 44.1 5 BIAS 36.6 10 BIAS 36.0 50 BIAS 35.1 50 BIAS + 1 DARK 61.4 50 BIAS + 5 DARK 42.2 50 BIAS + 10 DARK 39.4 50 BIAS + 30 DARK 36.2 50 BIAS + 30 DARK + 1 FLAT 37.3 50 BIAS + 30 DARK + 5 FLAT 37.2 50 BIAS + 30 DARK + 20 flat 37.2 Tutaj różnice są dość wyraźne, ponieważ filtry wąskopasmowe mocno tną sygnał i zarówno poziom jak i szum tła jest niewielki. Stąd procentowo udział szumu kalibracyjnego jest dość spory. To ile trzeba złożyć takich pojedynczych klatek? Klatek bias z 50 albo nawet 100, a czytałem o takich co i kilkaset składają - ich wykonanie niewiele kosztuje (chyba że mamy starą kamerkę CCD, która zapodaje klatkę do komputera przez minutę. Lustrzanki czy nowe CMOSy mogą zrobić kilka albo nawet kilkanaście klatek na sekundę). Klatek dark najlepiej robić nie mniej, niż mamy klatek z materiałem. Ale jak mamy 30 godzin materiału to nikt nie będzie wypalał przecież 30 godzin darków? No raczej nie. Wtedy zapominamy o darkach i stosujemy dithering i/albo usuwamy hot piksele programowo. Ale jak nasza matryca pamięta jeszcze zeszłe tysiąclecie i ma paskudny wzór termiczny, to darki niestety są wskazane. A ile flatów? A tak z 10 w zupełności starcza, ale porządnie naświetlonych. Flaty są normalizowane i nie są sumowane z materiałem i choć jest w nich sporo szumów, to nie jest on bezpośrednio dodawany do materiału. No spoko, ale przecież mamy od groma programów i sposobów na usuwanie szumu, to po co naświetlać tyle kaliklatek?! Hehe, po pierwsze - nie usuwanie, tylko redukcję. Po drugie - to bardzo dobrze, i warto je mieć, ale skoro już na wejściu możemy mieć mniejszy szum, to po redukcji wynik na pewno będzie lepszy. A po trzecie - w wielu algorytmach skuteczność redukcji szumu jest proporcjonalna do różnicy w skali pomiędzy redukowanym zjawiskiem (szumem) a tym, które chcemy zachować (obrazem). Jeśli najmniejsze detale obrazu mają rozmiar w okolicy 1px, to redukcja szumu siłą rzeczy będzie takie detale psuła i jej efektywność będzie niewielka. Warto więc dbać o to, żeby obraz nie był podpróbkowany - patrz pierwsza część. Jak często aktualizujemy klatki kalibracyjne? No, hm, to zależy. Wzór hot pikseli może się zmienić w każdej chwili, a i nowa padnięta kolumna może się pojawić dowolnym momencie. Podobnie syfki na filtrach mogą się przemieścić byle kiedy. Mając na celu prace ukierunkowane bardziej naukowo dobrze jest klatki kalibracyjne robić przed każdą sesją, a nawet przed i po. Również jak wymieniamy jakiś fragment elektroniki zestawu: kabel USB, hub USB, zasilacz, to może mieć to wpływ na wygląd klatek bias czy dark. Najlepiej uznać to po prostu za część procesu, bo bez tego etapu obróbki otrzymane wyniki zamiast wartości naukowych będą miały co najwyżej walory estetyczne: "o jaki ładny i gładki wykres fotometryczny przedstawiający to, co bym chciał". W każdym innym przypadku (np. kiedy robimy po prostu ładne zdjęcia) to, o ile w ogóle używamy klatek kalibracyjnych, aktualizujemy je, kiedy już zaczynamy zauważać, że słabo nam kalibrują materiał. Na przykład - nie usuwają hot pikseli albo padniętych kolumn, albo kleksów, pączków czy innych śladów z zanieczyszczeń na optyce. Najszybciej "starzeją" się klatki typ flat. Ogólnie z grubsza rzecz biorąc klatki flat aktualizujemy co kilka dni/tygodni. W przypadku biasów i darków są to tygodnie/miesiące. Jak wykonujemy klatki kalibracyjne? Biasy z czasem tak krótkim, jak kamerka pozwala i przy zasłoniętym obiektywie. Darki z czasem takim, jak klatki z materiałem i w ciemności - w końcu nazwa dark do czegoś zobowiązuje. Kamerki nie zawsze są światłoszczelne i robienie darków w dzień raczej nie da nam dobrych wyników. Ale już w lodówce na przykład - czemu nie? Podobno jak się zamknie lodówkę to światełko wewnątrz gaśnie i jest ciemno. W każdym razie u mnie darki z lodówki wychodziły dobrze. Zarówno darki i biasy robimy dla konkretnej temperatury. Niektóre programy potrafią dopasować w pewnym zakresie czas i temperaturę wykonania darka, jeśli parametry klatki z materiałem się nieco różnią, ale nie jest to tak dobra opcja jak dokładnie dobrana klatka dark pod względem czasu ekspozycji i temperatury. Niezbędne też są do tego procesu klatki bias. A klatki flat? O, tutaj to można napisać całe tomy na ten temat. Chyba nie ma dwóch amatorów astrofotografii, którzy robią klatki flat w ten sam sposób. W tej nierównej potyczce udział biorą t-shirty i flatownice, kartki papieru i sky flaty, wymyślne konstrukcje z LEDów, żarówek, kalki technicznej, zmatowionej pleksi i wiele, wiele innych sposobów. Ważne są trzy rzeczy: żeby histogram klatki flat był jak najdalej, ale nie dalej niż 3/4 wykresu (szum kontra nieliniowość kamerki), żeby pole widzenia instrumentu było jednolicie oświetlone i żeby klatki flat wykonywać dokładnie w takim ustawieniu elementów zestawu, jak klatki z materiałem. A więc odpowiednie ustawienia filtrów, ostrości oraz rotatora (o ile posiadamy). Jak używamy klatek kalibracyjnych? Jest wiele ścieżek prowadzących do celu. Najlepiej jednak przeczytać w instrukcji używanego przez nas programu w jaki sposób kalibrować materiał. Tam się dowiemy co, jak i w jakiej ilości dodać i jak kalibrować. Jak dla mnie referencyjnym rozwiązaniem dysponuje MaxIm DL z jego biblioteką kalibracyjną - nie spotkałem się z łatwiejszym podejściem do implementacji tego procesu. A wyniki są bardzo dobre. Takie same lub lepsze, niż w pozostałych programach, które testowałem w tej materii. Sama kalibracja przebiega trochę różnie, w zależności od rodzaju klatek, którymi dysponujemy: - BIAS: od materiału odejmowany jest sygnał bias - BIAS + DARK: od materiału odejmowany jest sygnał bias i dark, dodatkowo istnieje możliwość dopasowania sygnału dark do innego czasu ekspozycji - BIAS + DARK + FLAT: jak wyżej plus materiał dzielony jest przez znormalizowanego flata z odjętym sygnałem bias (to ważne! kalibrując flatami miejmy też biasy) Czasami jeszcze klatkom flat podaje się klatki dark wykonane w takich samych warunkach jak flaty (tzw. dark flaty). MaxIm wszystkie te kombinacje łyka jak młody pelikan ryby i potrafi zapanować nad całym stadem plików kalibracyjnych (o ile w nagłówku FITS mają odpowiednie informacje - temperaturę, czas ekspozycji i używany filtr). A jak składać klatki kalibracyjne? Podobnie jak każde inne. Przy klatkach dark i flat warto użyć jakiegoś algorytmu odrzucającego błędne piksele, np. Sigma Clip, żeby się pozbyć artefaktów pochodzących z promieniowania kosmicznego. Przy klatkach bias nie jest to krytyczne, bo czas ekspozycji jest znikomy. Coś jeszcze o klatkach kalibracyjnych? Na ich podstawie można co nieco wywnioskować o sprzęcie. Klatki flat to wiadomo, będzie widać winietę, odblaski i położenie syfków w torze optycznym. Odległość syfku od matrycy można obliczyć za pomocą kalkulatora http://www.wilmslowastro.com/software/formulae.htm#Dust . Z klatek dark dowiemy się jak wiele wad produkcyjnych ma matryca. Hot piksele na pewno jakieś będą. Padnięte kolumny mogą się zdarzyć też. Sąsiadujące ze sobą padnięte kolumny to już dość poważny defekt. Gradient albo pojaśnienia przy krawędziach klatki dark oznaczają najczęściej nierównomierne chłodzenie matrycy. W przypadku matryc CMOS za pojaśnienie może odpowiadać ciepło pracującej w pobliżu elektroniki - to tak zwany amp glow. Ale oprócz gradientu i wadliwych pikseli i kolumn nie powinniśmy raczej nic więcej tam widzieć. Na klatce bias z kolei powinniśmy widzieć jedynie szum oraz ewentualnie padnięte kolumny. Może też być (w przypadku przetworników CCD) być widoczny niewielki gradient w kierunku transferu ładunku (pionowo, poziomo albo po skosie), który wynika ze strat w transferze (pisałem o tym w poprzedniej części). I tyle. Szum powinien być jednolity i nie powinno być w nim żadnego powtarzalnego wzoru, co można łatwo sprawdzić przeprowadzając na fragmencie obrazu transformację Fouriera. Idealnie w jej wyniku powinniśmy dostać pośrodku obrazu jeden punkt. Wtedy też najlepiej działają algorytmy do redukcji losowego szumu. Coś jeszcze w okolicach kalibracji? Są jeszcze dwa tematy pokrewne - usuwanie wadliwych pikseli i kolumn mapą, oraz dithering. Niektóre programy oprócz czysto programowego usuwania defektów oferują usuwanie ich za pomocą przygotowanej wcześniej na podstawie klatki dark odpowiedniej mapy. Po wskazaniu klatki master dark i określeniu progów detekcji program znajduje i zapisuje położenie wadliwych piskeli na matrycy. Następnie możliwe jest użycie takiej mapy na klatce z materiałem w celu usunięcia artefaktów. Wartości w wadliwych pikselach zostają zastąpione średnią wartością z pikseli otaczających. Jeśli klatka dark naszej kamerki pokazuje jedynie hot piksele to spokojnie możemy używać takiej mapy bez wykonywania całej serii klatek typu dark, przez co zyskać możemy całkiem sporo czasu. Natomiast dithering to metoda, którą stosujemy podczas akwizycji materiału. Pomiędzy poszczególnymi zbieranymi klatkami kadr zostaje przesunięty o pewną losową ilość pikseli w losowo wybranym kierunku. Dzięki temu po wyrównaniu klatek na gwiazdach, hot piksele i inne artefakty lądują w różnych miejscach kadru i następnie zostają wyczyszczone przez algorytm składający materiał. Warunkiem koniecznym jest posiadanie sporej ilości klatek (jakoś z 10 albo więcej) oraz użycie algorytmu odrzucającego błędne piksele.1 punkt

-

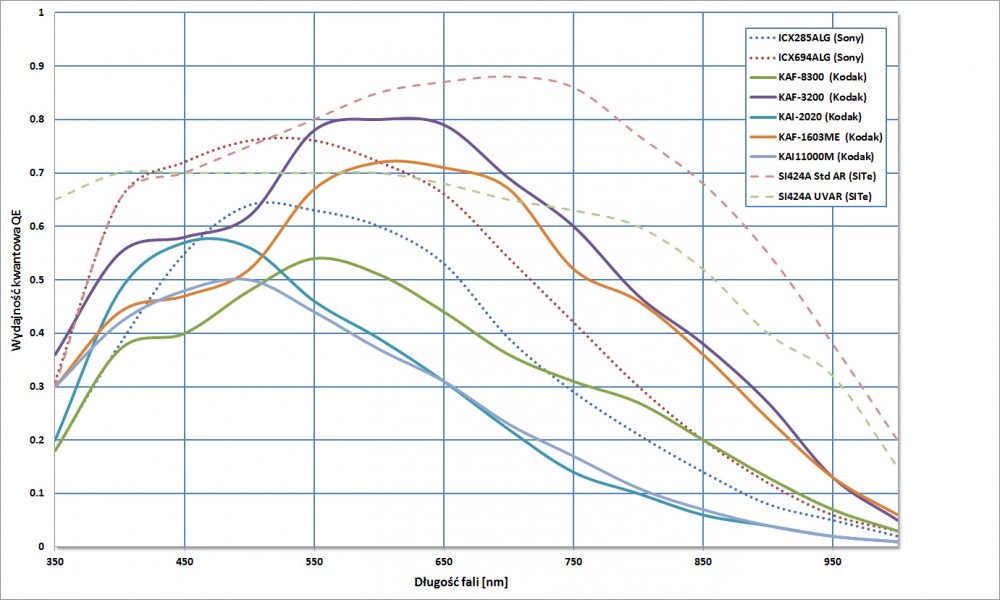

Od fotonów do megabajtów. Jak wiadomo światło (w ogólności promieniowanie elektromagnetyczne) cierpi na rozdwojenie jaźni. Część jego właściwości łatwiej opisać przypisując mu naturę falową (np zjawisko dyfrakcji, z których pośrednio wynika opisywana w poprzedniej części rozdzielczość optyki). A z kolei inne cechy światła lepiej opisywać z pomocą teorii korpuskularnej, która dzieli światło na małe cząsteczki - fotony. Z pomocą tej drugiej natury światła dużo łatwiej będzie opisać generowanie obrazu w matrycy światłoczułej. Na początek szczypta historii. Sensory używane w kamerach CCD zostały wynalezione, można powiedzieć, przez przypadek, albo raczej - przy okazji. W roku 1969 w laboratoriach firmy Bell Labs dwóch naukowców prowadziło badania nad opracowaniem nowego sposobu magazynowania danych dla ówczesnych maszyn cyfrowych. Jeden z pomysłów zaowocował powstaniem urządzenia, które okazało się być czułe na światło. Po 5 latach powstała pierwsza światłoczuła matryca o rozdzielczości 100x100 pikseli, a po kolejnych 5 latach wynalazek znalazł po raz pierwszy zastosowanie w astronomii. Urządzenie zostało nazwane Charged Coupled Device (w skrócie CCD). W porównaniu do stosowanej wcześniej emulsji światłoczułej nastąpił ogromny skok w czułości. Klasyczna fotografia pozwalała na uzyskanie sprawności kwantowej na poziomie 2-3%, a specjalnie uczulane klisze pozwalały zbliżyć się do około 10%. Oznaczało to, że na każde 100 fotonów padających na powierzchnię kliszy, jedynie kilka z nich było rejestrowane. Sprawność kwantowa matryc CCD szybko osiągnęła niespotykane wcześniej wartości zbliżając się do 100% [1]. Natomiast samo zjawisko, które jest odpowiedzialne za pracę matryc CCD to efekt fotoelektryczny, za wyjaśnienie którego Albert Einstein w 1921 roku otrzymał nagrodę Nobla (tak, właśnie za to, a nie za pracę nad teorią względności). Wykres QE kilku różnych matryc CCD Prace nad matrycami CCD posuwały się szybko do przodu i już w latach dziewięćdziesiątych ubiegłego stulecia zaczęły one powoli być używane przez amatorów astronomii. Obecnie trudno sobie wyobrazić jakiekolwiek działania w dziedzinie astronomii bez dobrodziejstw oferowanych przez urządzenia CCD. W tej części "astrofotografii od podszewki" spróbujemy prześledzić drogę fotonu począwszy od momentu w którym pada on na powierzchnię matrycy CCD. A raczej nie jednego fotonu, tylko jakiejś paczki, bo będzie nam potrzebna statystyka. Na początku warto będzie poruszyć dość abstrakcyjny temat związany z kwantową naturą światła. Otóż jeśli na przykład wiemy, że w ciągu sekundy w pikselu wylądowało 1000 fotonów, to moglibyśmy oczekiwać, że w ciągu następnej sekundy zamelduje się ich tam tyle samo (zakładając, że obserwujemy źródło światła o stałym natężeniu promieniowania). Ale niekoniecznie tak się stanie - może ich się tam pojawić 999, albo 1050, albo na przykład 967. Fluktuacje te są właśnie konsekwencją kwantowej natury światła, a prawdopodobieństwo pojawienia się konkretnej ilości fotonów opisuje rozkład Poissona. Niestety fluktuacje te przekładają się na zjawisko dla nas bardzo niekorzystne - na szum. Każde obserwowane przez nas źródło światła, czy to gwiazda, czy promieniowanie z tła nieba będzie od samego początku obarczone szumem - szum ten zwany jest szumem fotonowym, a jego wartość to pierwiastek kwadratowy z wartości sygnału. Czyli sygnał z naszego obiektu z którego w ciągu sekundy średnio ląduje w pikselu kamerki 1000 fotonów jeszcze przed dotarciem do matrycy już jest obarczone szumem fotonowym. Kilka klatek typu flat naświetlanych do około połowy histogramu. Możemy zauważyć jak ogromny jest szum w takiej klatce (ponad 280ADU) - jest to połączony szum fotonowy z szumem zjawiska fotoelektrycznego. W momencie zarejestrowania fotonu przez detektor, powstaje z niego elektron, zwany też fotoelektronem. Prawdopodobieństwo udanej konwersji fotonu w elektron opisuje parametr zwany sprawnością kwantową detektora. Sprawność kwantowa (ang. quantum efficiency, QE) matrycy zmienia się wraz z długością fali promieniowania. Dla kamerek używanych przez amatorów maksimum czułości przypada najczęściej w okolicach barwy zielonej albo żółtej. QE jest bardzo istotnym parametrem kamery i ma ogromny wpływ na otrzymywane wyniki, a trzeba pamiętać, że istnieje spory rozrzut wartości QE w zależności od modelu matrycy. Matryca z QE na poziomie 30% podłączona do instrumentu o aperturze 100mm da nam takiej samej jakości obrazy, jak matryca o sprawności 60% podłączona do instrumentu o aperturze 70mm, a więc jest o co walczyć. Dodatkowo, jeśli planujemy wykonywać sporo zdjęć np w zakresie H alpha warto zwrócić uwagę na sprawność matrycy dla tej konkretnej długości fali. Zazwyczaj różnice tu są jeszcze większe, niż w środku pasma widzialnego w okolicach 550nm. Ale pojęcie "sprawność kwantowa" do czegoś zobowiązuje, skoro jest kwantowa, to raczej nie będzie się zachowywała do końca przewidywalnie. Sytuacja będzie podobna jak w przypadku szumu fotonowego. Sprawność kwantowa o wartości 50% nie oznacza, że każde 1000 fotonów zostanie przekonwertowane dokładnie na 500 elektronów. Może to być znowu więcej albo mniej, albo też dokładnie 500. Jak się łatwo domyślić, ta specyficzna właściwość kamery będzie niestety kolejnym źródłem szumu. Zjawisko to będzie dotyczyło każdej matrycy o sprawności poniżej 100%. Załóżmy, że nasz przykładowy sensor ma sprawność kwantową 50%. Czyli nasze 1000 fotonów na sekundę zostało przekonwertowane średnio na 500 elektronów na sekundę, a do szumu fotonowego doszedł szum wynikający z losowości zjawiska fotoelektrycznego. Obecnie w naszej kamerce trwa ekspozycja i w każdej sekundzie w studni potencjału pomiędzy bramkami piksela pojawia się średnio 500 nowych fotoelektronów. Ale czy tylko? Niestety nie. Pojawiają się też elektrony będące wynikiem przepływu przez matrycę tak zwanego prądu ciemnego (ang. dark current). Prąd ten płynie nawet przez zupełnie nieoświetloną matrycę, a jego wartość rośnie wraz z temperaturą. Wzrost temperatury o 6*C powoduje dwukrotne zwiększenie prądu ciemnego, dlatego sensory kamerek są chłodzone - ma to na celu ograniczenie prądu ciemnego i związanego z nim szumu. Szum powiązany z prądem ciemnym poddaje się rozkładowi Poissona i jego wartość jest równa pierwiastkowi kwadratowemu z wartości prądu ciemnego. Po lewej klatka bias, po prawej dark z czasem ekspozycji 300s. Na klatce typu dark możemy zauważyć hot piksele i artefakty powstałe w wyniku działania promieniowania kosmicznego, ale sam poziom szumu wzrósł bardzo nieznacznie. Prąd ciemny i związany z nim szum termiczny stanowią bardzo mały ułamek całkowitego szumu. W lewej dolnej części widać też częściowo wadliwą kolumnę matrycy. Naszą ekspozycję zaplanowaliśmy na 30 sekund, czas ten właśnie upłynął i ekspozycja się zakończyła. W pikselu zebrało się około 30000 fotoelektronów i pewna ilość elektronów mających swoje źródło w prądzie ciemnym. Na tym etapie elektrony te są już nierozróżnialne i tworzą po prostu uwięziony w studni potencjału piksela sygnał. Po zakończeniu ekspozycji następuje proces odczytu elektronów z matrycy. Wygląda to inaczej w matrycach CCD i matrycach CMOS. W tych pierwszych podczas odczytu zarejestrowany w postaci elektronów sygnał transferowany jest przez kolejne kolumny i wiersze do rejestru wyjściowego matrycy i stamtąd dopiero trafia do wzmacniacza. Efektem ubocznym takiego procesu są pewne straty w transferze ładunku, ale we współczesnych matrycach CCD są one bardzo niewielkie. W matrycach CMOS dla odmiany każdy piksel otoczony jest swoim własnym małym zestawem elektroniki, który jest odpowiedzialny za funkcjonowanie i odczyt sygnału. Ale w obu typach matryc proces odczytu obarczony jest, a jakże, kolejnym źródłem szumu - jest to szum odczytu. Zostaje on dodany do zebranego w pikselu sygnału podczas jego odczytu z matrycy. Jego wartość nie zależy od czasu ekspozycji i w niewielkim stopniu zależy od temperatury. "Czysty" szum odczytu możemy zobaczyć na klatkach wykonanych z bardzo krótkim czasem ekspozycji i zakrytą matrycą (są to klatki kalibracyjne typu BIAS). Wtedy nie zostanie zarejestrowany ani sygnał świetlny, ani nie zdąży się zebrać ładunek z prądu ciemnego i dostaniemy na wyjściu jedynie szum odczytu. I tu już powoli historia fotonów dobiega końca. Po drodze zostały przemielone na elektrony, doprawione zakłóceniami z różnych źródeł, odczytane, wzmocnione i na końcu trafiają do przetwornika analogowo-cyfrowego (ang. analog-digital converter, ADC). Tam zmieniają się z sygnału analogowego w postać cyfrową. Najważniejszy parametr przetwornika ADC to jego rozdzielczość, wyraża się ją w bitach. Obecnie wśród amatorskich kamerek CCD dominują przetworniki o rozdzielczości 16 bitów, natomiast w kamerkach z matrycami CMOS są to najczęściej przetworniki 12 lub 14 bitowe. Sygnał odczytany z piksela jest wzmacniany, a następnie jako napięcie podawany na wejście przetwornika ADC i opuszcza go w postaci cyfrowej, gotowej do dalszej obróbki albo do zapisania na dysku. Konwersja sygnału analogowego w postać cyfrową wiąże się z dwoma potencjalnymi problemami - nieliniowością przetwornika (rzadko spotykany problem), oraz szumem kwantyzacji (w porównaniu z pozostałymi źródłami szumu to ostatnie ma znikomy udział w całkowitym szumie). Po konwersji w przetworniku ADC wartość sygnału mierzymy już w ADU (ang. analog-to-digital units). Wartość ta będzie zależała od wzmocnienia zastosowanego w elektronice kamerki oraz od rozdzielczości przetwornika ADC. Przykładowo dla kamerki Atik383 współczynnik wzmocnienia wynosi 0.45e-/ADU, czyli każde 45 elektronów odczytane z piksela będzie dawało na wyjściu przetwornika sygnał o wartości 100ADU. Od lewej - klatka bias, 300s dark oraz fragment Drogi Mlecznej z czasem ekspozycji również 300s. Opis w tekście. Na obrazie powyżej możemy zaobserwować proporcje pomiędzy różnymi źródłami szumu napotykanymi w trakcie ekspozycji. Mamy obok siebie pokazane trzy różne obrazy na tym samym wycinku kadru z matrycy kamerki Atik383 - każdy z nich naświetlano przy temperaturze sensora -20*C. Pierwsza klatka z lewej to klatka typu bias, widzimy na niej czysty szum - jest to szum odczytu. Pośrodku klatka dark naświetlana z czasem 300 sekund - możemy zauważyć kilka hot pikseli, jednak szum w tle pozostaje praktycznie bez zmian. Klatka typu dark zawiera w sobie sygnał z klatki bias plus prąd ciemny i jak widać w tym przypadku ten prąd ciemny i związany z nim szum termiczny jest bardzo niewielki. Ostatni kadr po prawej stronie to fragment Drogi Mlecznej naświetlany również przez 300 sekund pod niebem o jasności około 20mag/arcsec2, a więc w warunkach raczej średnich. Możemy zaobserwować ogromny przyrost poziomu tła oraz szumu z nim związanego - ponad 95% szumu w tym kadrze pochodzi z promieniowania tła nieba. I zazwyczaj tak właśnie będzie, ponieważ chodzi o to, żeby nie ograniczały nas narzędzia których używamy, czyli w tym przypadku kamera CCD. Istnieje jeszcze jeden dość istotny parametr matrycy, o którym nie wspomniałem do tej pory - pojemność piksela (ang. pixel well depth, full well depth). Jest to po prostu ilość elektronów, które piksel w swojej studni potencjału może pomieścić zanim zaczną one się z niego "wylewać" na sąsiednie, połączone z nim piksele. Pojemność piksela jest mocno skorelowana z fizycznymi rozmiarami piksela. Piksele o wielkości 4-5um mają najczęściej pojemność około 20000 elektronów, piksele 10um mogą pomieścić 60-80 tysięcy elektronów, a większe - jeszcze więcej. To oczywiście są wartości poglądowe. Kiedy piksel zapełni się elektronami, a na jego powierzchnię wciąż padają fotony uwalniając kolejne elektrony, mamy do czynienia ze zjawiskiem nazywanym po angielsku blooming, czyli "przelewanie" się elektronów do sąsiednich pikseli. Zjawisko to powoduje trudne do usunięcia artefakty wokół jasnych źródeł światła. Na szczęście z pomocą przychodzą stosowane w wielu matrycach bramki ABG (ang. anti blooming gates), które powodują odprowadzenie z przepełnionego piksela nadmiaru elektronów i prawie każda kamerka amatorska jest w takie dobrodziejstwo wyposażona. Zastosowanie bramek ABG wiąże się z pewnym zmniejszeniem zarówno czułości jak i pojemności piksela, ale korzyść dla amatorów astrofotografii jest bezcenna. A jak już opisujemy pojemność piksela, to jeszcze jeden parametr, tym razem wielkość pochodna - dynamika sensora (ang. dynamic range, DR). Jest najczęściej wyrażana jako stosunek pojemności piksela do szumu odczytu i wyrażana jest bezpośrednio jak ten iloraz, jako wielkość logarytmiczna w decybelach, albo w jednostkach EV (ang. exposure value). Efekt bloomingu. Żródło: http://info.adimec.com/blogposts/bid/104645/Blooming-suppression-and-Smear-rejection-with-CCD-machine-vision-cameras Przykładowo dla kilku kamerek będziemy mieli: - dla Atika383 mamy pojemność piksela 25000 e-, a szum odczytu równy jest 10e-, czyli DR = 2500, albo 68dB, albo 11.2EV - a np dla kamerki ASI1600 mamy (dla gain=0) pojemność piksela 20000e, szum odczytu 3.5e-, czyli DR = 5700, albo 75dB, albo 12.4EV - i jeszcze kamerka Moravian G3-1000 z sensorem Kodaka KAF-1001 - piksel 220 000e-, szum odczytu 17e-, czyli DR = 13000, albo 82dB, albo 13.6EV Dynamika wyrażona w EV jest też bezpośrednią informacją o tym, jakiej rozdzielczości musimy zastosować przetwornik analogowo-cyfrowy, żeby na etapie konwersji nie utracić informacji. Jak widać w przypadku Atika 383 mającego przetwornik 16 bitowy jest on zastosowany mocno na wyrost, bo do pokrycia dynamiki tego sensora wystarczy 12 bitów. Natomiast w przypadku ASI1600 przydałoby się nieco więcej, niż 12 bitów przetwornika ADC. Ale we współczesnych kamerach CMOS możemy dowolnie zmieniać ustawienia gain i offset i dobrać optymalny dla własnych zastosowań zakres pracy kamerki. No to jak wyciągnąć ile się da z naszej kamerki? musimy zmaksymalizować ilość zebranego sygnału. Wydłużamy czas całkowitej ekspozycji i składamy wiele pojedynczych klatek w jedną całość. Im więcej czasu poświęcimy na zebranie materiału, tym lepszy będzie wynik. Trzeba jednak pamiętać, że jakość materiału będzie się poprawiała coraz wolniej. Jeśli mamy na przykład 2 godziny materiału i dodamy kolejne 2, to poprawa będzie oczywista. Ale jak mamy na przykład już zebrane 10 godzin materiału i dopalimy kolejne 2 godziny, to jakość zdjęcia nie polepszy się nam w tak wyraźny sposób. Inne sposoby na zmaksymalizowanie uzysku materiału w czasie sesji to stosowanie kamerki o dużej sprawności (wysokie QE), dobre prowadzenie i dokładnie ustawiona ostrość i oczywiście większa apertura instrumentu wybieramy kamerkę z niskim szumem odczytu oraz małym prądem termicznym. Co prawda stosując odpowiednio długie pojedyncze ekspozycje możemy zminimalizować wpływ szumu odczytu na końcowy wynik, ale po co ma nas ten parametr ograniczać. Duży szum odczytu obniża nam dynamikę kamerki i trudniej jest znaleźć kompromis pomiędzy szumami w ciemnych partiach obrazu, a nie przepalaniem najjaśniejszych ograniczamy jasność tła nieba. Ciemna miejscówka jest oczywistą odpowiedzią, a jeśli to niemożliwe możemy się posiłkować filtrami LP. Warto również osłaniać zestaw przed światłem bocznym oraz wyeliminować wewnętrzne odbicia. Nie przyciemni nam to nieba, ale jeśli zignorujemy te zjawiska, to stosunek sygnału do szumu nam się jeszcze bardziej pogorszy kalibrujmy prawidłowo materiał - o tym więcej w kolejnej części. [1] w szczególnych przypadkach, teoretycznie, sprawność matrycy może przekroczyć 100% - jeśli padający foton ma bardzo dużą energię, to może spowodować wybicie więcej niż jednego elektronu1 punkt

4.thumb.jpg.f2c5edee91cdb9f608d0ef1d939dd94e.jpg)

7.thumb.jpg.ae152edb3cc526571037c3bd918fa623.jpg)

1.thumb.jpg.8f1b353504024a54ecf04590def6366a.jpg)

2.thumb.jpg.639d7756318e2f13f9d4cbbfe8d2c367.jpg)

6.thumb.jpg.d1d6389bcfaa2f6bd473388f691a7dc4.jpg)

.thumb.jpg.fc1816e6f50cce1c6606ff64cbbabc15.jpg)

.thumb.gif.04d7295045e997b427757ff59cb38c47.gif)